首页>平台建设成果

首页>平台建设成果二、问题分析:本文从内在偏差和外在偏差两个维度深入分析了VML任务中的数据偏差问题:

内在偏差(Intrinsic Bias)

1. 输入输出信息不平衡:VML任务要求模型从大量的视觉和文本信息中提取相对稀疏的时间戳信息,这种巨大的信息差异导致模型倾向于学习简单的时间戳分布规律,形成"捷径学习"。

2. 时刻边界模糊性:视频中的动作通常呈现连续过渡,精确界定时刻边界存在主观性。而现有方法使用绝对帧索引来表示边界,边界帧包含的语义信息不足以完整捕获时刻内容,相邻帧的相似性进一步加剧了边界的不确定性。

外在偏差(Extrinsic Bias)

1. 长尾分布偏差:VML数据集中动词和名词呈现明显的长尾分布,高频词汇主导模型训练,而低频的尾部词汇往往包含更多判别性信息却被忽视。

2. 语义偏差:由于尾部样本训练数据有限,简单的重加权策略可能导致模型在尾部样本上过拟合,产生训练-测试分布不匹配的语义偏差。

三、技术方案

为了系统性地解决上述偏差问题,本文提出了一个混合去偏Transformer网络架构,包含以下核心技术模块。

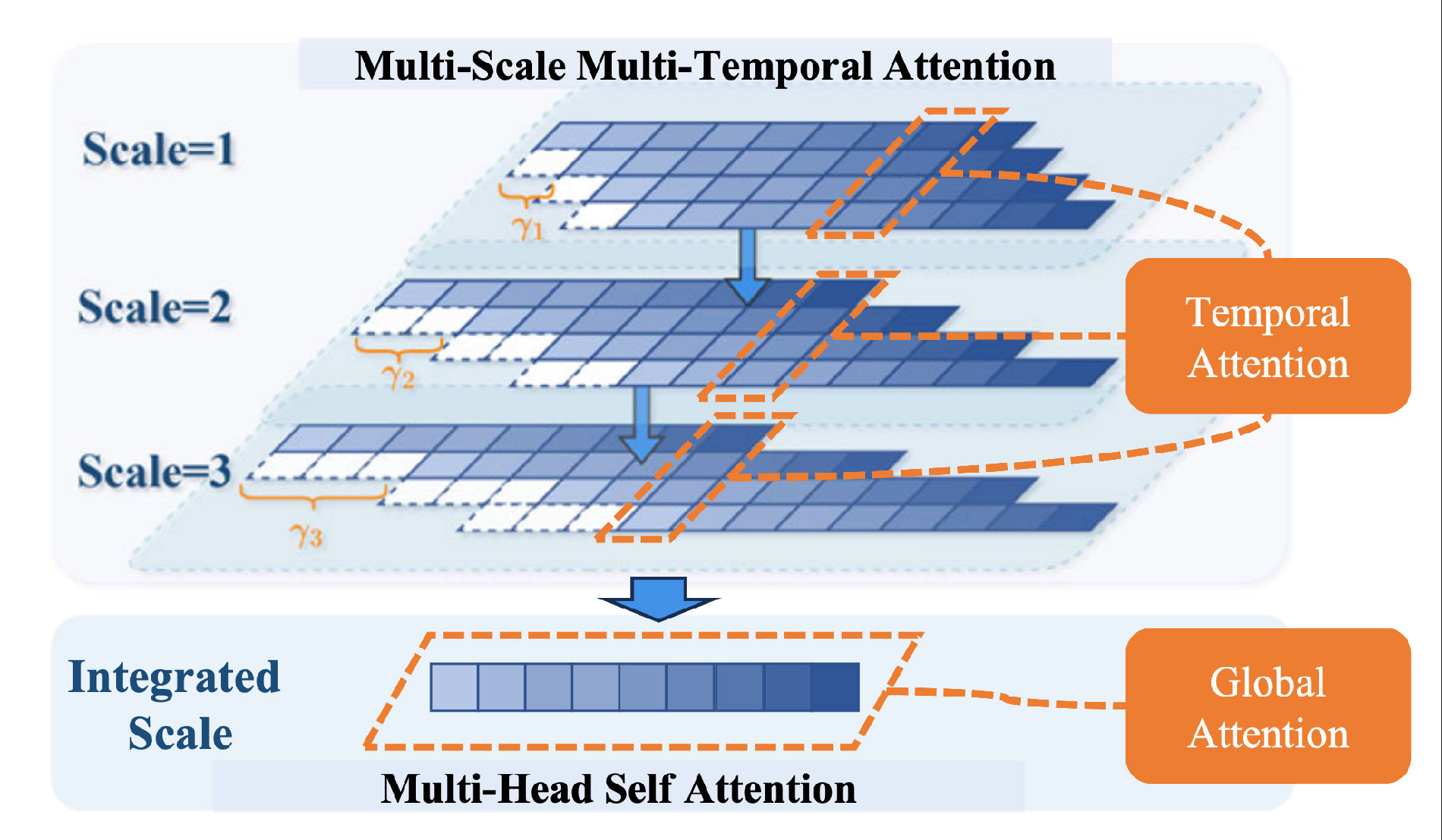

首先是多时序Transformer(Multi-Temporal Transformer, MTT)模块。如图1 所示, 该模块通过多尺度时序注意力机制,将帧级特征聚合为段级表示,动态适应模糊的时刻边界。MTT采用多尺度时序注意力,在不同时间间隔上建模局部时序关系,同时设计前向和后向时序流,捕获双向时序依赖。通过分层时序建模,系统性地从细粒度动作编码到长程依赖建模,有效缓解边界模糊性导致的内在偏差,显著提升时刻定位的精确性。

图1 多尺度多时序注意力框架示意图。时序特征在通过全局注意力整合之前在不同尺度上进行处理,实现分层时序建模。

其次是时序一致性约束(Temporal Consistency Constraint, TCC)模块。该约束通过限制不同分支的视觉特征与动词正则化嵌入的一致性来突出动作信息。具体而言,TCC使用KL散度度量静态分支和动态分支特征与动词嵌入的对齐程度,在训练过程中仅保留目标时刻对应的视觉特征进行约束,引导模型关注视频中的动作细节,避免过度依赖静态背景信息。这种设计有效缓解了输入输出信息不平衡导致的内在偏差,提升了模型对视频内容的深层理解能力。

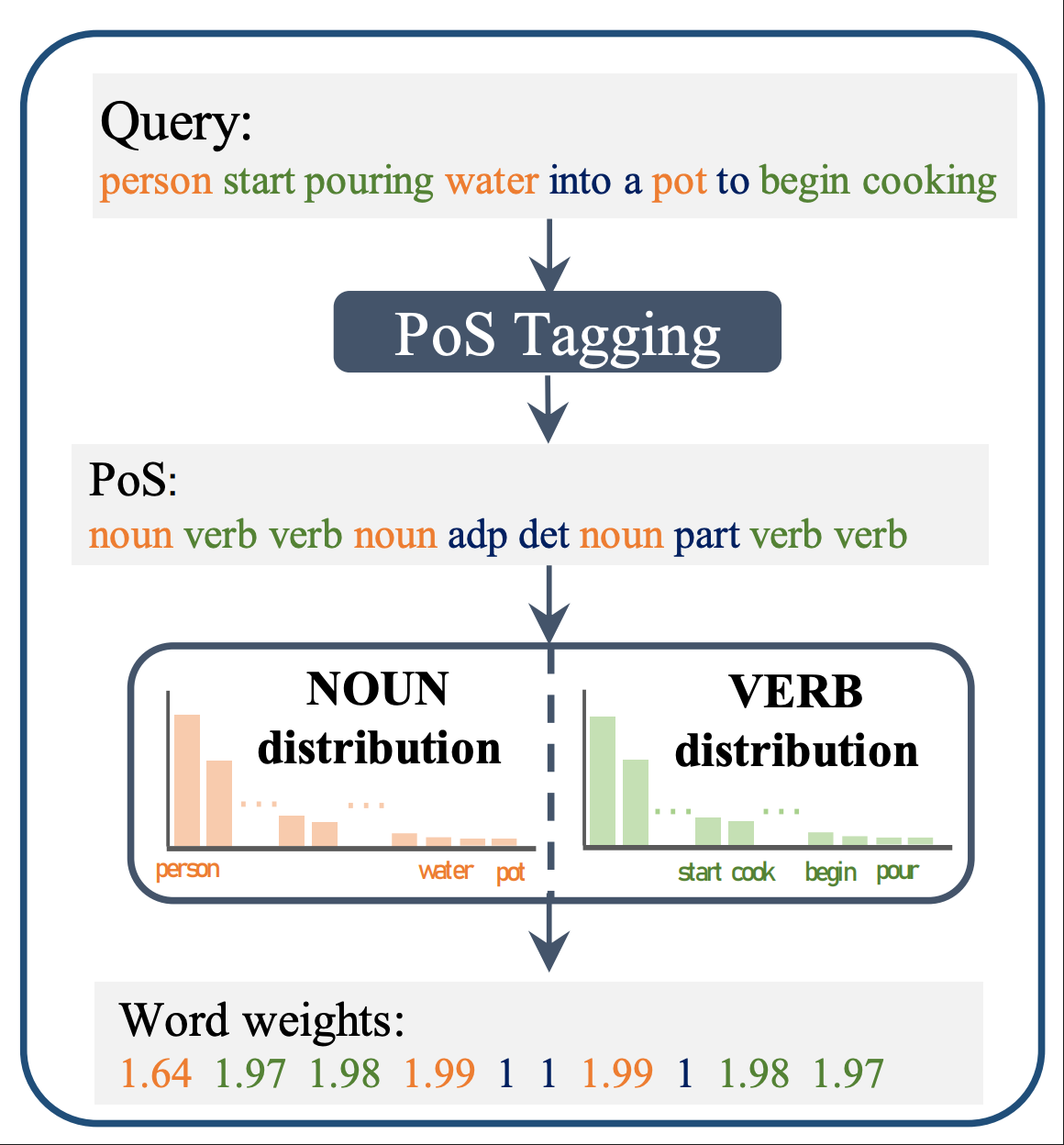

第三个核心模块是混合语言激活模块(Hybrid Linguistic Activation, HLA)。如图2所示,该模块基于数据集级别的词频统计,为尾部词汇分配更高的注意力权重。对于动词和名词,权重计算公式为WpoS=2-Fq,其中Fq为词频归一化值。这种简单而有效的重加权机制能够突出低频关键词,同时保持句子的全局语义完整性,为后续的先验引导Transformer提供重要的数据集级别先验知识。

图2 混合语言激活模块示意图。该模块基于词汇在数据集中的出现频率计算静态注意力权重,从而强调不常见词汇的表示。

第四个关键模块是先验引导Transformer(Prior-Guided Transformer, PGT)。该模块的核心创新在于引入可学习的语义正则化嵌入,在充分利用HLA先验知识的同时有效防止尾部样本过拟合问题。PGT采用分离的动词和名词处理分支来增强特征多样性,通过词到词注意力机制建立词汇间的复杂关联,语义正则化嵌入则负责学习数据集级别的全局语义分割。在具体工作机制上,HLA生成的权重作用于语义嵌入与句子特征的注意力计算,嵌入通过自适应学习来平衡尾部词汇关注度和语义一致性,有效避免了直接重加权词特征可能导致的过拟合问题。

最后是混合多层级融合机制。该机制包含实体感知融合和动作感知融合两个分支,前者让静态分支重点关注名词,精确对齐视频帧中的物体信息,后者使动态分支强调动词,准确捕获视频段中的动作信息。整个融合过程采用多层级策略,先进行词级交叉注意力计算,再通过语义级注意力融合全局语义信息,实现了细粒度特征对齐和高层语义理解的有机结合。

四、实验验证

本文在三个标准数据集上进行了全面的实验评估。Charades-STA数据集包含16,128个室内活动视频标注,ActivityNet Captions数据集涵盖37,417个YouTube视频训练样本,TACoS数据集提供18,818个烹饪场景视频标注。实验采用R@n, IoU=μ和mIoU作为评估指标,其中μ,取值为0.3、0.5和0.7。

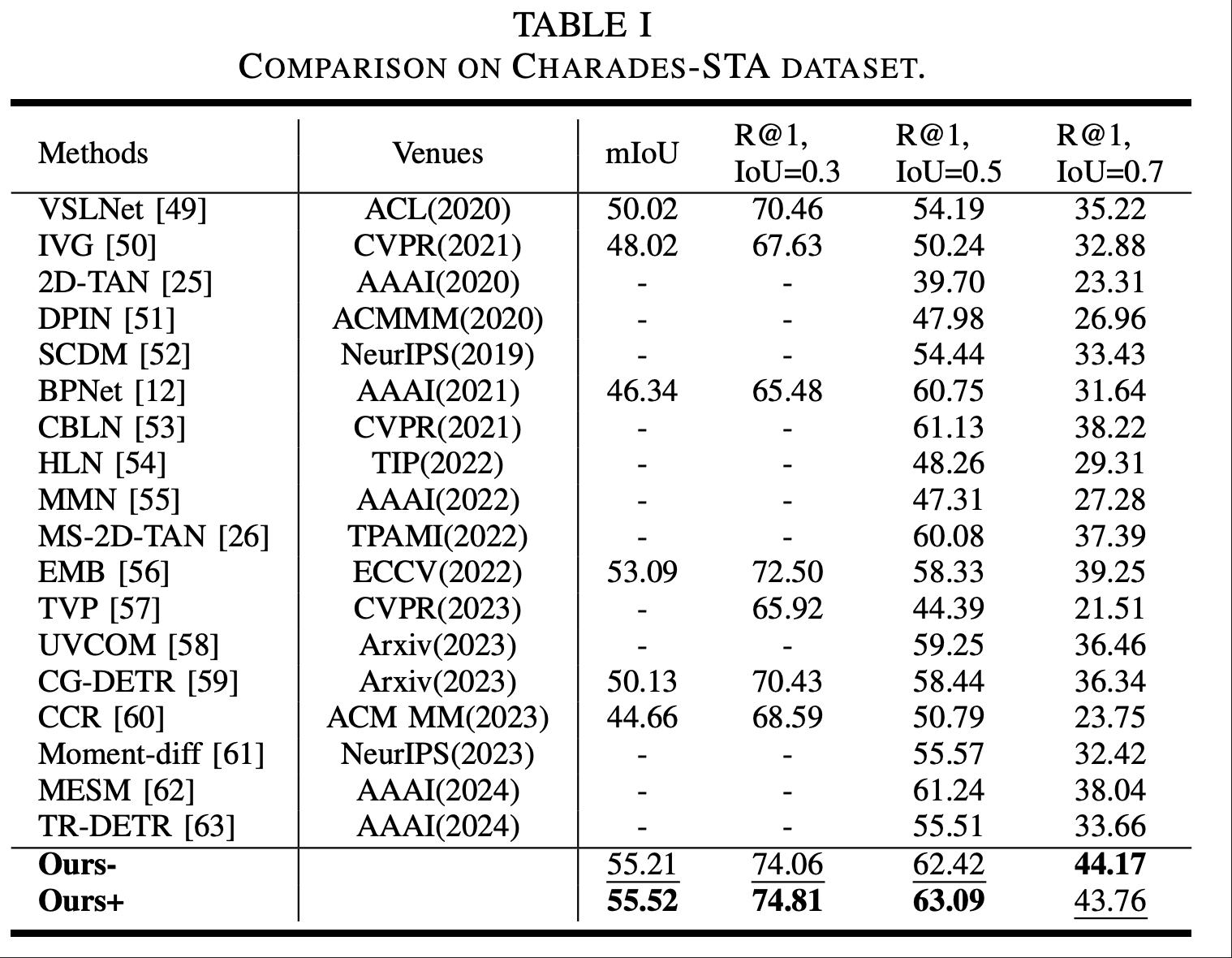

表1 在Charades-STA数据集上的性能表现

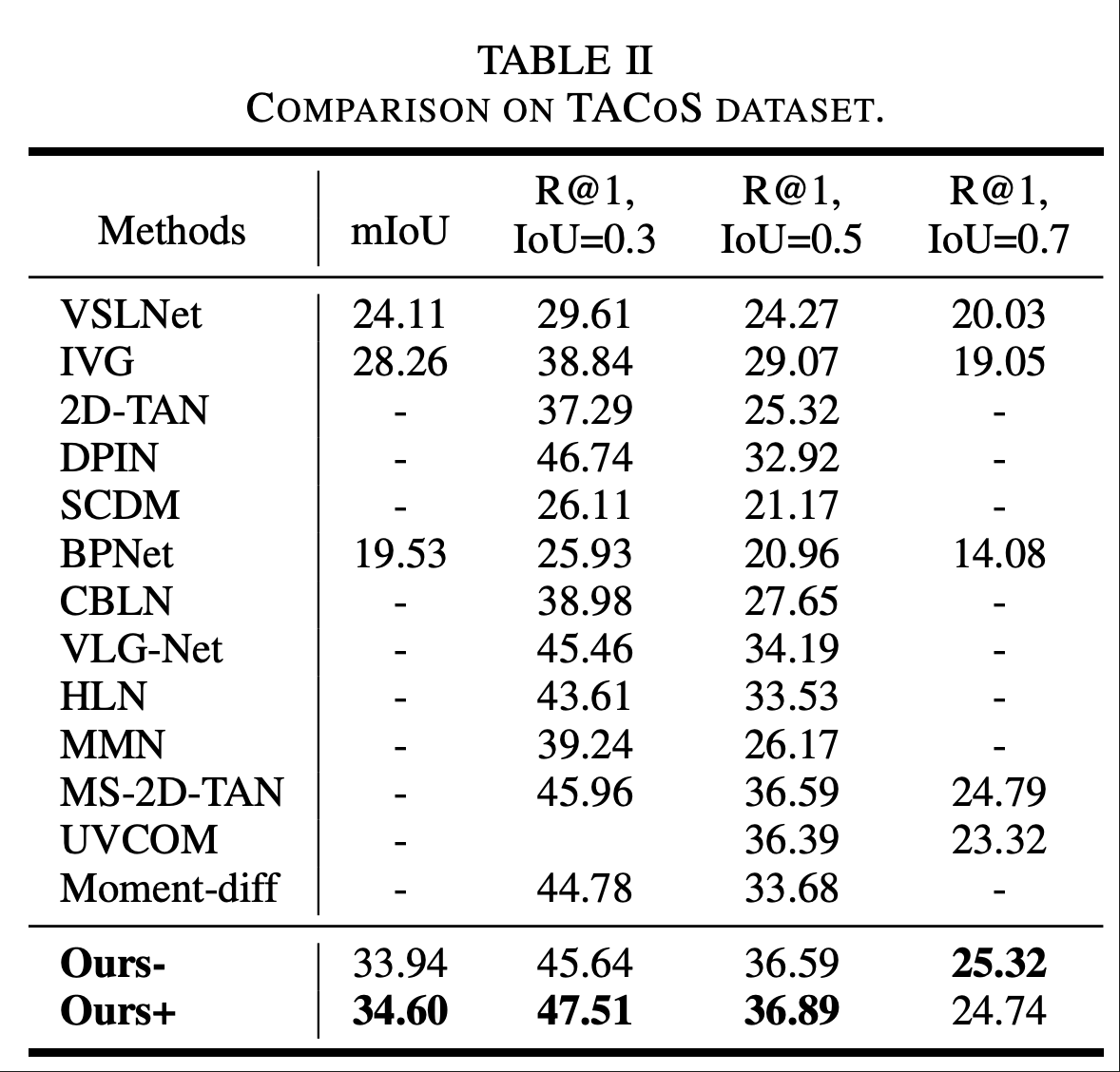

如表1,表2所示,在标准数据集性能方面,本文方法取得了显著的改进效果。在Charades-STA数据集上,方法的mIoU达到55.52%,R@1,IoU=0.7达到43.76%,相比现有最佳方法有明显提升。在TACoS数据集上,mIoU达到34.60%,显著超越了现有方法的性能。在ActivityNet Captions数据集上,方法保持了竞争性的表现,证明了其在不同类型视频内容上的适应性。

表2 在TACoS数据集上的性能表现

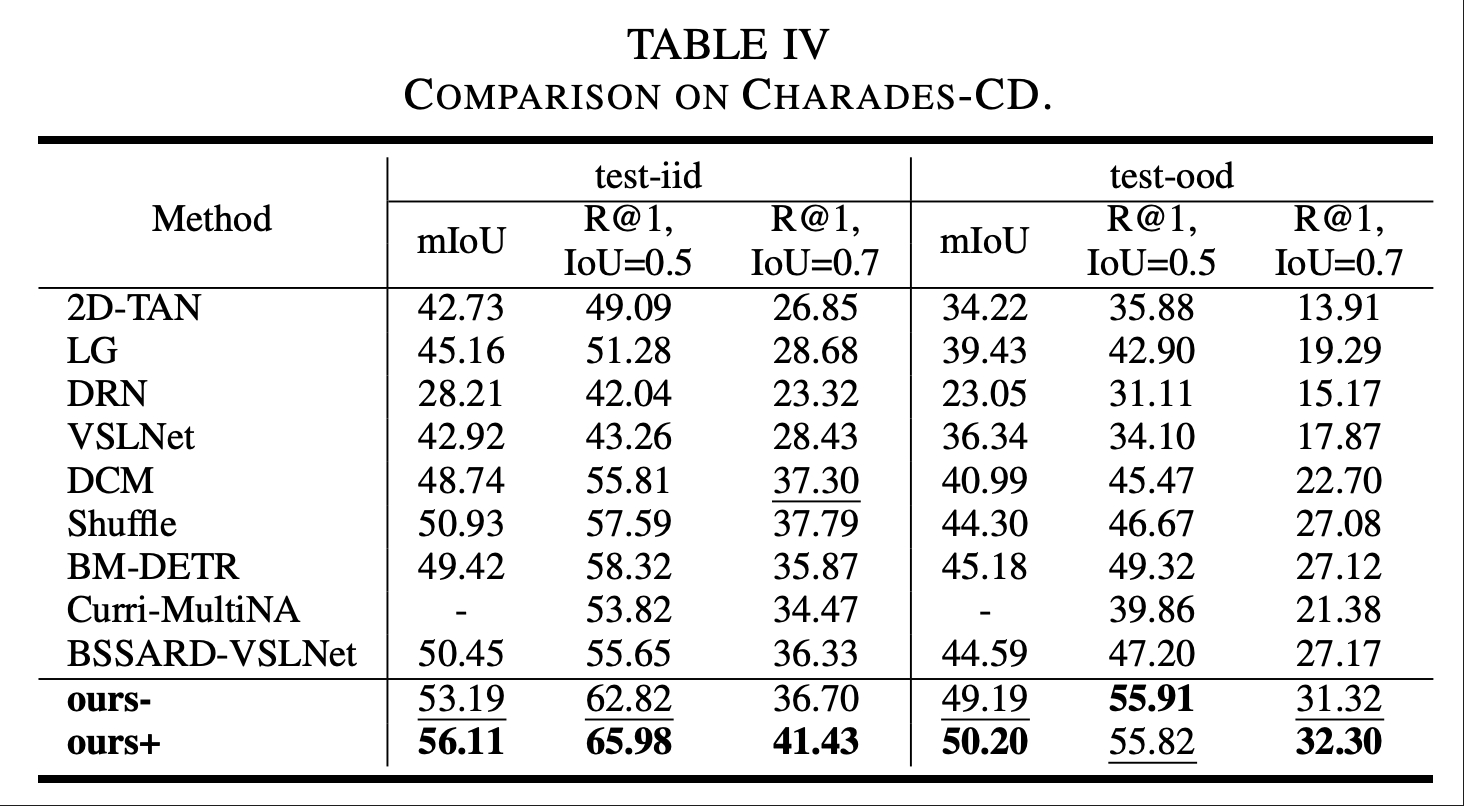

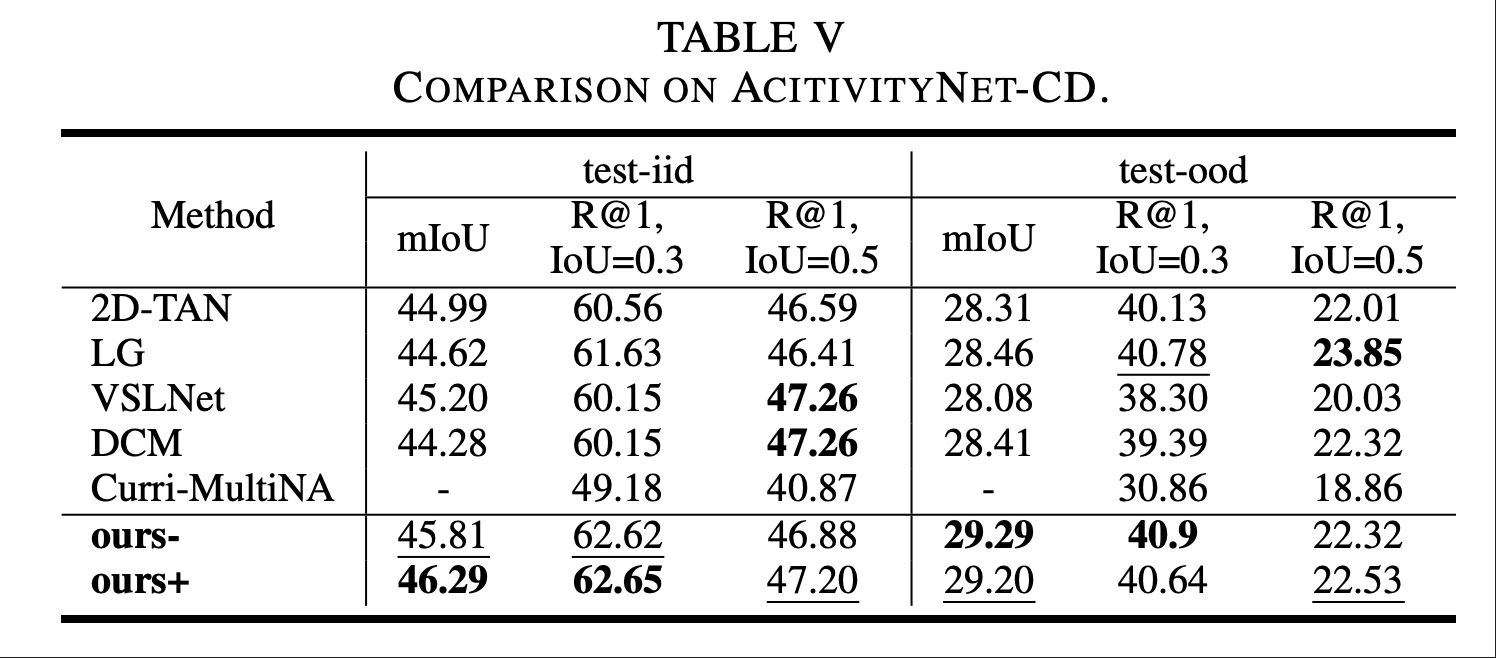

为了验证方法的去偏能力,该工作在重新划分的去偏数据集上进行了专门测试。如表3所示,在Charades-CD数据集的out-of-distribution测试集上,方法的mIoU达到50.20%,显著优于现有的去偏方法,证明了模型具有优异的跨分布泛化能力。这一结果表明,所提出的方法确实能够避免过度依赖训练数据的分布偏差,具备了更强的实际应用价值。

表3 在Charades-CD数据集上的性能表现

表4 在Activity-CD数据集上的性能表现

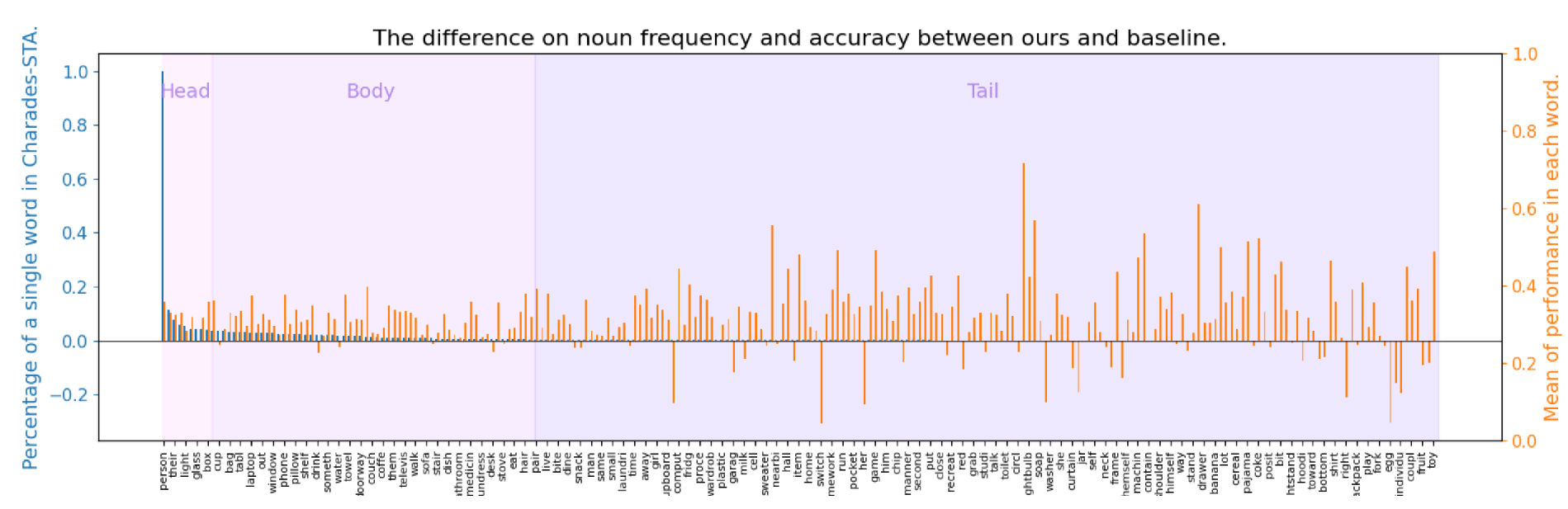

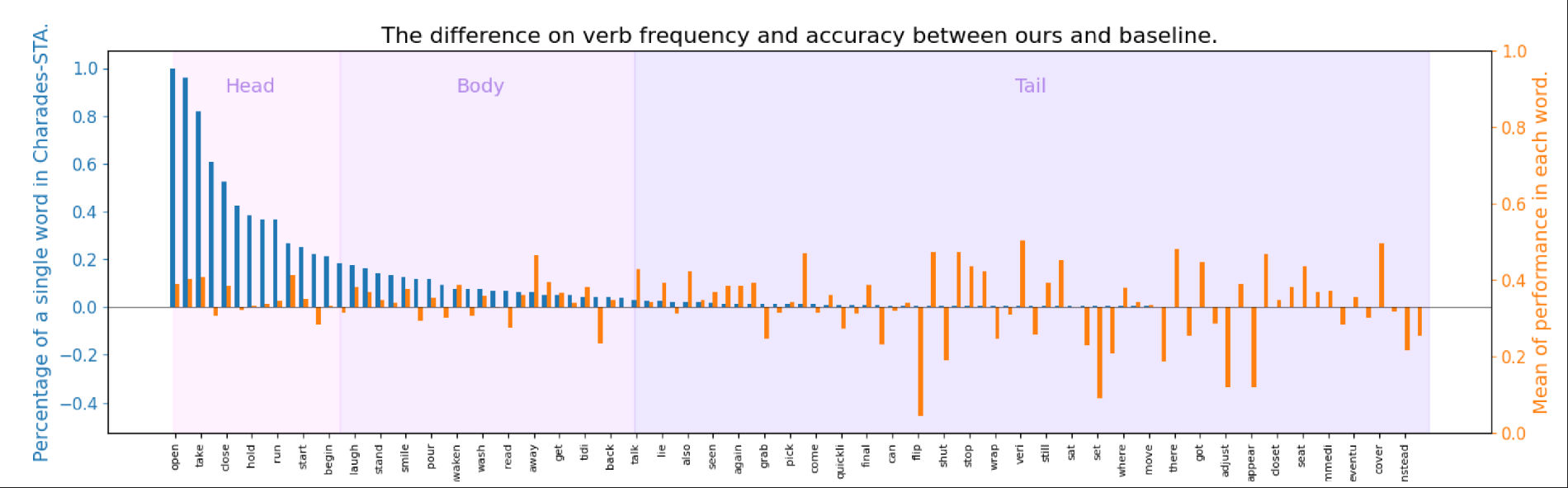

如图3,图4所示,通过对长尾分布处理效果的可视化分析,研究者发现模型对低频名词和动词的处理能力得到显著提升。具体而言,在保持高频词汇原有性能的前提下,模型对尾部词汇的定位精度实现了大幅改善,验证了混合语言激活模块和先验引导Transformer的有效性。

图3该方法与基线方法在名词频率和准确率方面的差异。该实验可视化了名词的长尾分布,并将该方法与基线方法对每个名词进行比较。

图4该方法与基线方法在名词频率和准确率方面的差异。该实验可视化了动词的长尾分布,并将该方法与基线方法对每个名词进行比较。

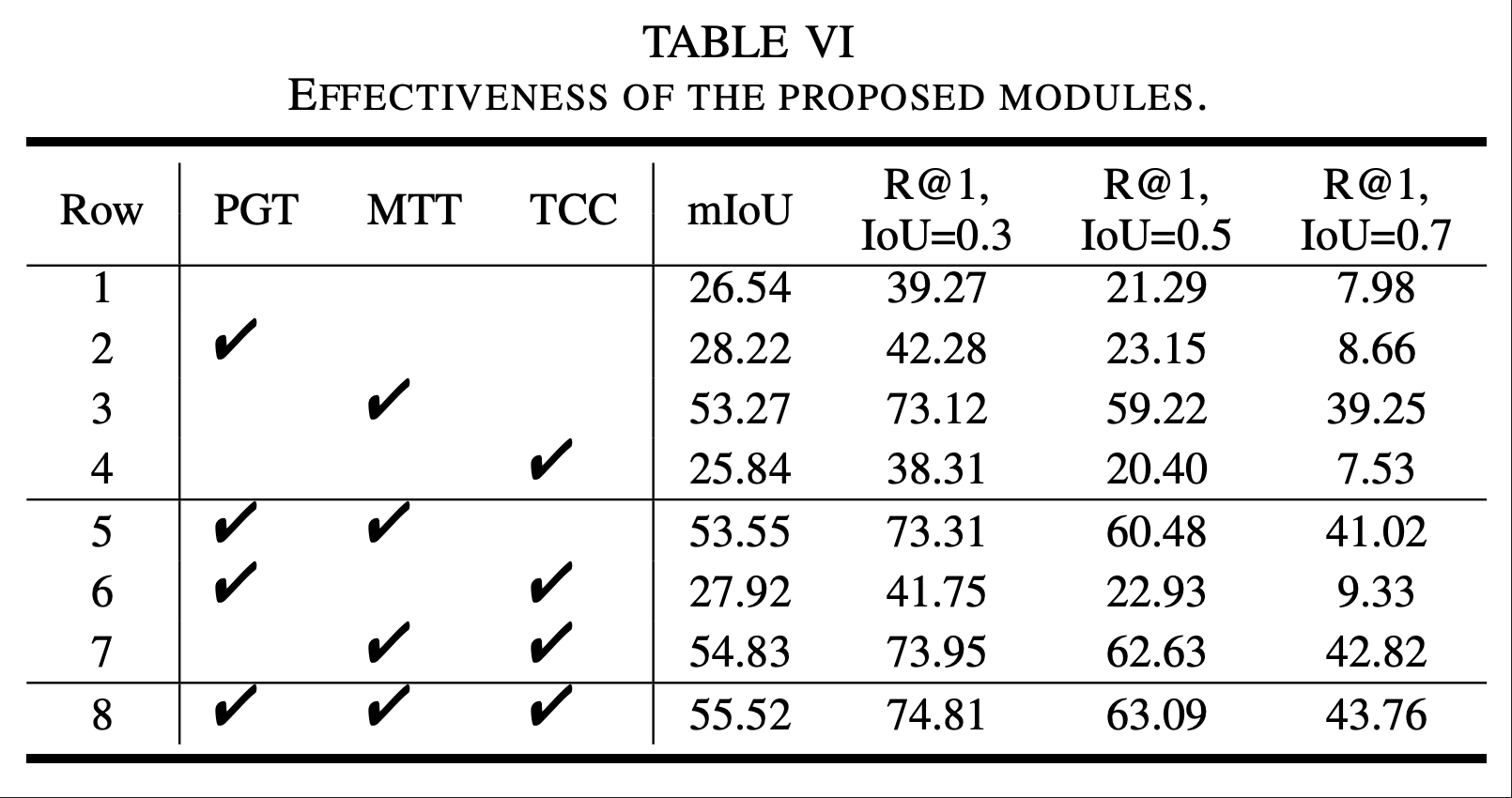

详细的消融实验进一步验证了各个技术模块的贡献。如表5所示,多时序Transformer模块单独带来了26.73% mIoU的显著性能提升,证明了其在处理边界模糊问题上的有效性。时序一致性约束进一步贡献了1.97% mIoU的改进,体现了动作信息强化的价值。先验引导Transformer和混合语言激活模块的组合则有效平衡了去偏效果和泛化能力,避免了简单重加权策略可能导致的过拟合问题。

表5该方法的模块消融实验

五、技术创新与贡献

本文的主要贡献体现在理论、方法和实用价值三个层面。在理论贡献方面,研究首次从内在和外在两个维度系统性地分析了VML任务中的数据偏差问题,为该领域的偏差研究提供了全新的理论分析框架。这种分类方法不仅有助于深入理解偏差产生的根源,也为后续相关研究提供了重要的理论指导。

在方法创新方面,本文提出了多项原创性技术。多时序Transformer通过多尺度时序建模有效处理了边界模糊问题,这是VML任务中长期存在的挑战。自适应正则化机制的设计巧妙地平衡了去偏效果和泛化能力,避免了传统去偏方法容易产生的过拟合问题。时序一致性约束的创新性引入为跨模态对齐提供了新的思路,通过强化动作信息来提升模型的理解能力。

在实用价值方面,所提出的方法不仅在标准数据集上取得了优异的性能表现,更重要的是在专门设计的去偏数据集上展现出色的鲁棒性。这一特点证明了方法在实际应用场景中的可靠性和有效性。